Thuật toán được xây dựng và thiết kế cho một loại mô hình cụm cụ thể thường sẽ không thành công khi được thiết lập để hoạt động trên tập dữ liệu có chứa một loại mô hình cụm rất khác. Vậy quy định về hiệu ứng phân nhóm là gì, ví dụ về hiệu ứng Clustering được quy định như thế nào?

Mục lục bài viết

1. Hiệu ứng phân nhóm là gì?

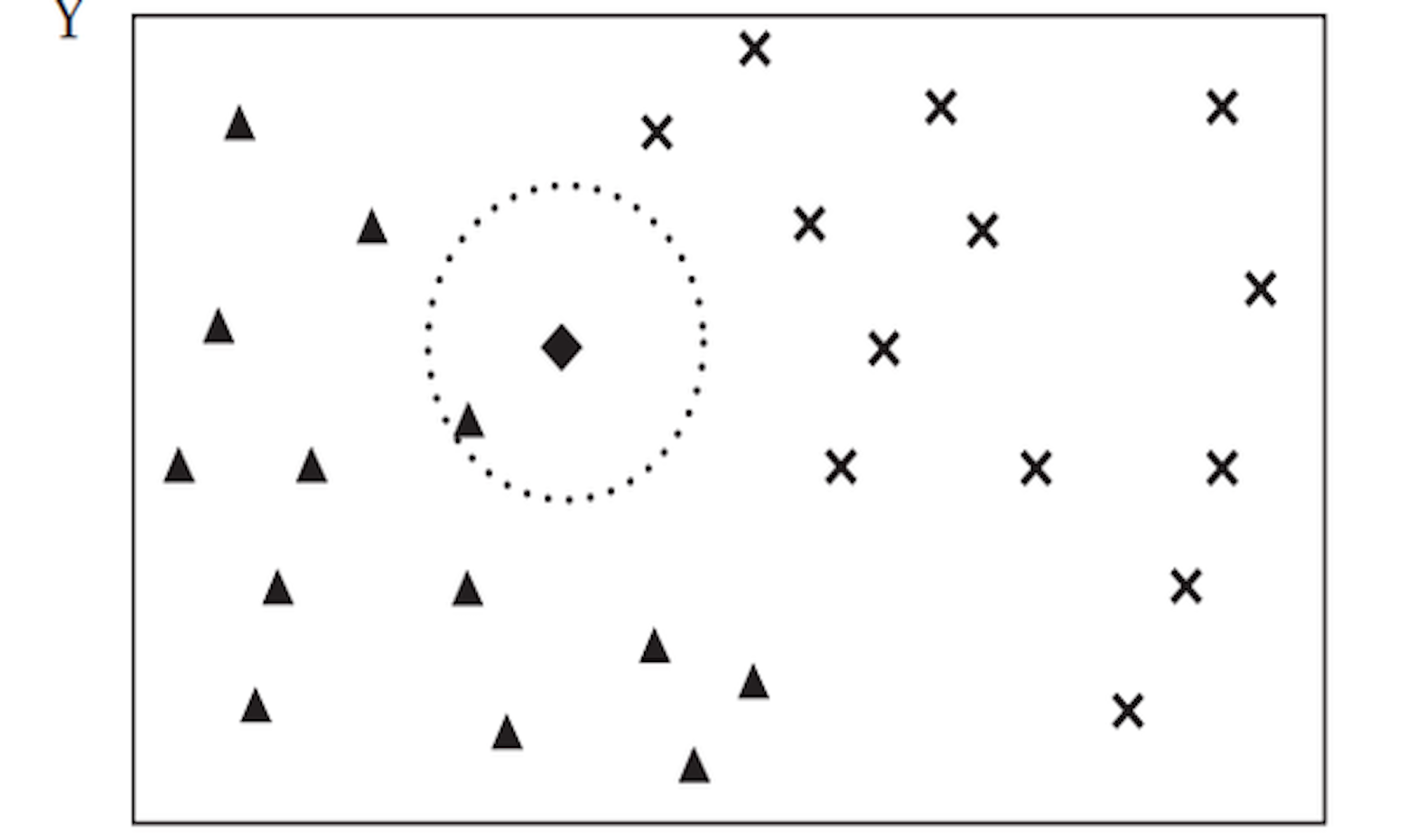

– Khái niệm Hiệu ứng phân nhóm: Phân tích cụm là việc nhóm các đối tượng sao cho các đối tượng trong cùng một cụm giống với nhau hơn so với các đối tượng trong một cụm khác. Việc phân loại thành các cụm được thực hiện bằng cách sử dụng các tiêu chí như khoảng cách nhỏ nhất, mật độ điểm dữ liệu, đồ thị hoặc các phân bố thống kê khác nhau. Phân tích cụm có khả năng ứng dụng rộng rãi, bao gồm học máy không giám sát, khai thác dữ liệu, thống kê, Phân tích đồ thị, xử lý hình ảnh và nhiều ứng dụng khoa học vật lý và xã hội.

– Các lý do phải thực hiện hiệu ứng phân nhóm: Các nhà khoa học dữ liệu và những người khác sử dụng phân cụm để có được những hiểu biết quan trọng từ dữ liệu bằng cách quan sát nhóm (hoặc cụm) mà các điểm dữ liệu rơi vào khi họ áp dụng thuật toán phân nhóm cho dữ liệu. Theo định nghĩa, học không giám sát là một loại học máy tìm kiếm các mẫu trong tập dữ liệu không có nhãn có sẵn và có sự can thiệp tối thiểu của con người. Phân cụm cũng có thể được sử dụng để phát hiện bất thường nhằm tìm ra các điểm dữ liệu không thuộc bất kỳ cụm nào hoặc các điểm ngoại lai.

Phân cụm được sử dụng để xác định các nhóm đối tượng tương tự trong bộ dữ liệu có hai hoặc nhiều đại lượng thay đổi. Trên thực tế, dữ liệu này có thể được thu thập từ cơ sở dữ liệu tiếp thị, y sinh hoặc không gian địa lý, cùng nhiều nơi khác.

Hiệu ứng phân nhóm tiếng anh là Clustering.

2. Tìm hiểu về Hiệu ứng phân nhóm:

Điều quan trọng cần lưu ý là phân tích các cụm không phải là công việc của một thuật toán đơn lẻ. Thay vào đó, các thuật toán khác nhau thường đảm nhận nhiệm vụ phân tích rộng hơn, mỗi thuật toán thường khác biệt đáng kể so với các thuật toán khác. Lý tưởng nhất là thuật toán phân cụm tạo ra các cụm trong đó độ tương đồng trong cụm là rất cao, có nghĩa là dữ liệu bên trong cụm rất giống nhau. Ngoài ra, thuật toán nên tạo các cụm trong đó mức độ tương tự giữa các cụm ít hơn nhiều, có nghĩa là mỗi cụm chứa thông tin càng khác biệt với các cụm khác càng tốt.

Luồng chung trong tất cả các thuật toán phân cụm là một nhóm các đối tượng dữ liệu. Nhưng các nhà khoa học dữ liệu và lập trình viên sử dụng các mô hình cụm khác nhau, với mỗi mô hình yêu cầu một thuật toán khác nhau. Clusterings hoặc tập hợp các cụm thường được phân biệt là phân cụm cứng trong đó mỗi đối tượng thuộc về một cụm hoặc không, hoặc phân cụm mềm trong đó mỗi đối tượng thuộc từng cụm ở một mức độ nào đó.

Điều này hoàn toàn khác với cái gọi là phân cụm máy chủ, thường đề cập đến một nhóm các máy chủ làm việc cùng nhau để cung cấp cho người dùng tính khả dụng cao hơn và giảm thời gian chết do một máy chủ tiếp quản khi một máy chủ khác tạm thời bị lỗi.

Các phương pháp phân tích phân cụm bao gồm:

+ Means tìm các cụm bằng cách giảm thiểu khoảng cách trung bình giữa các điểm hình học.

+ DBSCAN sử dụng phân cụm không gian dựa trên mật độ.

+ Phân cụm phổ là một thuật toán dựa trên đồ thị tương tự mô hình hóa các mối quan hệ láng giềng gần nhất giữa các điểm dữ liệu dưới dạng một đồ thị vô hướng.

+ Phân cụm phân cấp nhóm dữ liệu thành một cây phân cấp đa cấp của các đồ thị có liên quan bắt đầu từ cấp tốt nhất (ban đầu) và tiến tới cấp thô nhất.

3. Phân cụm các trường hợp sử dụng:

Với số lượng ngày càng tăng của các thuật toán phân cụm có sẵn, không có gì ngạc nhiên khi phân nhóm đã trở thành một phương pháp luận quan trọng trên nhiều loại hình tổ chức và doanh nghiệp, với các trường hợp sử dụng khác nhau. Các trường hợp sử dụng phân cụm bao gồm phân tích trình tự sinh học, phân nhóm gen người, phân nhóm mô hình ảnh y tế, phân khúc thị trường hoặc khách hàng, nhóm mạng xã hội hoặc kết quả tìm kiếm cho các đề xuất, phát hiện sự bất thường của mạng máy tính, xử lý ngôn ngữ tự nhiên để phân nhóm văn bản, phân tích nhóm tội phạm và nhóm khí hậu phân tích. Dưới đây là mô tả của một số ví dụ.

Phân loại lưu lượng mạng. Các tổ chức tìm kiếm nhiều cách khác nhau để hiểu các loại lưu lượng truy cập khác nhau vào trang web của họ, đặc biệt là thư rác là gì và lưu lượng truy cập đến từ bot. Clustering được sử dụng để nhóm lại các đặc điểm chung của các nguồn lưu lượng, sau đó tạo các cụm để phân loại và phân biệt các loại lưu lượng. Điều này cho phép chặn lưu lượng truy cập đáng tin cậy hơn đồng thời cho phép hiểu rõ hơn về việc thúc đẩy tăng trưởng lưu lượng truy cập từ các nguồn mong muốn. Tiếp thị và bán hàng. Tiếp thị thành công có nghĩa là nhắm mục tiêu đúng người hoặc khách hàng tiềm năng theo đúng cách. Các thuật toán phân cụm nhóm những người có đặc điểm giống nhau lại với nhau, có lẽ dựa trên khả năng mua hàng của họ. Với các nhóm hoặc cụm này được xác định, hoạt động tiếp thị thử nghiệm trên các nhóm hoặc nhóm đó trở nên hiệu quả hơn, giúp tinh chỉnh thông điệp để tiếp cận họ.

4. Ví dụ về hiệu ứng Clustering:

Ví dụ về hiệu ứng Clustering:

Bất kỳ tổ chức nào xử lý khối lượng lớn tài liệu sẽ được hưởng lợi bằng cách có thể hoặc

phân phối chúng một cách hiệu quả và nhanh chóng khi chúng được tạo. Điều đó có nghĩa là có thể hiểu các chủ đề cơ bản trong tài liệu và sau đó có thể so sánh chủ đề đó với các tài liệu khác. Thuật toán phân cụm kiểm tra văn bản trong tài liệu, sau đó nhóm chúng thành các cụm có chủ đề khác nhau. Bằng cách đó, chúng có thể được sắp xếp nhanh chóng theo nội dung thực tế.

– Các nhà khoa học dữ liệu và phân cụm: Như đã lưu ý, phân cụm là một phương pháp học máy không có giám sát. Máy học có thể xử lý khối lượng dữ liệu khổng lồ, cho phép các nhà khoa học dữ liệu dành thời gian phân tích dữ liệu và mô hình đã xử lý để có được thông tin chi tiết hữu ích. Các nhà khoa học dữ liệu sử dụng phân tích phân cụm để có được một số thông tin chi tiết có giá trị từ dữ liệu của chúng tôi bằng cách xem các điểm dữ liệu rơi vào nhóm nào khi họ áp dụng thuật toán phân nhóm.

Phân tích cụm đóng một vai trò quan trọng trong nhiều ứng dụng, nhưng hiện nó đang phải đối mặt với thách thức tính toán do khối lượng dữ liệu liên tục tăng. Tính toán song song với GPU là một trong những giải pháp hứa hẹn nhất để vượt qua thách thức tính toán.

GPU cung cấp một cách tuyệt vời để tăng tốc phân tích dữ liệu chuyên sâu và phân tích đồ thị nói riêng, vì mức độ song song lớn và lợi thế băng thông truy cập bộ nhớ. Kiến trúc song song khổng lồ của GPU, bao gồm hàng nghìn lõi nhỏ được thiết kế để xử lý nhiều tác vụ đồng thời, rất phù hợp cho tác vụ tính toán “cho mọi lần X làm Y”. Điều này có thể áp dụng cho các tập hợp các đỉnh hoặc các cạnh trong một đồ thị lớn. Phân tích cụm là một vấn đề với tính song song đáng kể và có thể được tăng tốc bằng cách sử dụng GPU. Thư viện NVIDIA Graph Analytics (nvGRAPH) sẽ cung cấp cả kỹ thuật phân nhóm / phân vùng phổ và phân cấp dựa trên số liệu cắt cân bằng tối thiểu trong tương lai. Thư viện nvGRAPH có sẵn miễn phí như một phần của Bộ công cụ NVIDIA® CUDA®. Để biết thêm thông tin về đồ thị, vui lòng tham khảo trang Phân tích đồ thị.

Bộ thư viện phần mềm nguồn mở NVIDIA RAPIDS ™, được xây dựng trên CUDA-X AI ™, cung cấp khả năng thực thi các đường ống phân tích và khoa học dữ liệu đầu cuối hoàn toàn trên GPU. Nó dựa trên các nguyên tắc NVIDIA CUDA® để tối ưu hóa máy tính mức thấp, nhưng thể hiện tính song song của GPU và tốc độ bộ nhớ băng thông cao thông qua giao diện Python thân thiện với người dùng.

Các thuật toán học máy cuML và các nguyên thủy toán học của RAPIDS tuân theo API giống như scikit-learning quen thuộc. Các thuật toán phổ biến như K-means, XGBoost và nhiều thuật toán khác được hỗ trợ cho cả việc triển khai GPU đơn và trung tâm dữ liệu lớn. Đối với các tập dữ liệu lớn, các triển khai dựa trên GPU này có thể hoàn thành nhanh hơn 10-50 lần so với các CPU tương đương của chúng.