Hiện nay, khi công nghệ thông tin ngày càng trở nên phát triển thì việc quản lý và ghị nhận các nội dung và số liệu trên các trang mạng thông tin ngày càng lớn và nó được gọi chung là dữ liệu. Khi dữ liệu ngày càng lớn mạnh thì việc nhận diện các nội dung liên quan đến dữ liệu cũng sẽ dễ dàng hơn. Vậy dữ liệu lớn là gì? Những khó khăn khi sử dụng dữ liệu lớn

Mục lục bài viết

1. Dữ liệu lớn là gì?

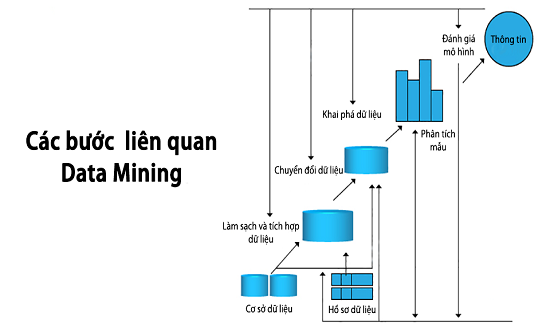

Dữ liệu lớn đề cập đến các tập hợp thông tin đa dạng, lớn phát triển với tốc độ ngày càng tăng. Nó bao gồm khối lượng thông tin, tốc độ hoặc tốc độ mà nó được tạo ra và thu thập cũng như sự đa dạng hoặc phạm vi của các điểm dữ liệu được bao phủ (được gọi là “ba v” của dữ liệu lớn). Dữ liệu lớn thường đến từ việc khai thác dữ liệu và có nhiều định dạng.

Dữ liệu lớn là một lượng lớn thông tin đa dạng đến với khối lượng ngày càng tăng và với tốc độ ngày càng cao. Dữ liệu lớn có thể có cấu trúc (thường là số, dễ dàng định dạng và lưu trữ) hoặc không có cấu trúc (dạng tự do hơn, ít định lượng hơn).

Gần như mọi bộ phận trong công ty đều có thể sử dụng các phát hiện từ phân tích dữ liệu lớn, nhưng việc xử lý sự lộn xộn và nhiễu của nó có thể gây ra nhiều vấn đề. Dữ liệu lớn có thể được thu thập từ các bình luận được chia sẻ công khai trên mạng xã hội và trang web, được thu thập tự nguyện từ các thiết bị điện tử và ứng dụng cá nhân, thông qua bảng câu hỏi, mua sản phẩm và đăng ký điện tử. Dữ liệu lớn thường được lưu trữ nhiều nhất trong cơ sở dữ liệu máy tính và được phân tích bằng phần mềm được thiết kế đặc biệt để xử lý các tập dữ liệu lớn, phức tạp.

Dữ liệu lớn có thể được phân loại là không có cấu trúc hoặc có cấu trúc. Dữ liệu có cấu trúc bao gồm thông tin đã được tổ chức quản lý trong cơ sở dữ liệu và bảng tính; nó thường là số trong tự nhiên. Dữ liệu phi cấu trúc là thông tin không có tổ chức và không nằm trong mô hình hoặc định dạng được xác định trước. Nó bao gồm dữ liệu thu thập từ các nguồn truyền thông xã hội, giúp các tổ chức thu thập thông tin về nhu cầu của khách hàng.

Dữ liệu lớn có thể được thu thập từ các bình luận được chia sẻ công khai trên mạng xã hội và trang web, được thu thập tự nguyện từ các thiết bị điện tử và ứng dụng cá nhân, thông qua bảng câu hỏi, mua sản phẩm và đăng ký điện tử. Sự hiện diện của các cảm biến và các đầu vào khác trong các thiết bị thông minh cho phép thu thập dữ liệu trên nhiều trường hợp và hoàn cảnh. Dữ liệu lớn thường được lưu trữ nhiều nhất trong cơ sở dữ liệu máy tính và được phân tích bằng phần mềm được thiết kế đặc biệt để xử lý các tập dữ liệu lớn, phức tạp. Nhiều công ty phần mềm dưới dạng dịch vụ (SaaS) chuyên quản lý loại dữ liệu phức tạp này.

Định nghĩa về dữ liệu lớn là dữ liệu có chứa nhiều loại dữ liệu hơn, đến với khối lượng ngày càng tăng và với tốc độ nhanh hơn. Đây còn được gọi là ba chữ V. Nói một cách đơn giản, dữ liệu lớn là những tập dữ liệu lớn hơn, phức tạp hơn, đặc biệt là từ các nguồn dữ liệu mới. Các tập dữ liệu này quá lớn đến nỗi phần mềm xử lý dữ liệu truyền thống không thể quản lý chúng. Nhưng khối lượng dữ liệu khổng lồ này có thể được sử dụng để giải quyết các vấn đề kinh doanh mà trước đây bạn không thể giải quyết.

Mặc dù bản thân khái niệm dữ liệu lớn còn tương đối mới, nhưng nguồn gốc của tập dữ liệu lớn bắt nguồn từ những năm 1960 và 1970 khi thế giới dữ liệu chỉ mới bắt đầu với các trung tâm dữ liệu đầu tiên và sự phát triển của cơ sở dữ liệu quan hệ. Khoảng năm 2005, mọi người bắt đầu nhận ra lượng dữ liệu mà người dùng tạo ra thông qua Facebook, YouTube và các dịch vụ trực tuyến khác. Hadoop (một khuôn khổ mã nguồn mở được tạo đặc biệt để lưu trữ và phân tích các tập dữ liệu lớn) đã được phát triển cùng năm đó. NoSQL cũng bắt đầu trở nên phổ biến trong thời gian này.

Sự phát triển của các khuôn khổ mã nguồn mở, chẳng hạn như Hadoop (và gần đây là Spark) là điều cần thiết cho sự phát triển của dữ liệu lớn vì chúng làm cho dữ liệu lớn dễ làm việc hơn và lưu trữ rẻ hơn. Trong những năm kể từ đó, khối lượng dữ liệu lớn đã tăng vọt. Người dùng vẫn đang tạo ra một lượng lớn dữ liệu – nhưng không chỉ con người đang làm việc đó.

Với sự ra đời của Internet of Things (IoT), nhiều đối tượng và thiết bị hơn được kết nối với internet, thu thập dữ liệu về cách sử dụng của khách hàng và hiệu suất sản phẩm. Sự xuất hiện của học máy đã tạo ra nhiều dữ liệu hơn. Mặc dù dữ liệu lớn đã tiến xa, nhưng tính hữu ích của nó chỉ mới bắt đầu. Điện toán đám mây đã mở rộng khả năng dữ liệu lớn hơn nữa. Đám mây cung cấp khả năng mở rộng thực sự đàn hồi, nơi các nhà phát triển có thể chỉ cần xoay tròn các cụm đặc biệt để kiểm tra một tập hợp con dữ liệu. Và cơ sở dữ liệu biểu đồ cũng ngày càng trở nên quan trọng, với khả năng hiển thị lượng lớn dữ liệu theo cách giúp phân tích nhanh chóng và toàn diện.

2. Những khó khăn khi sử dụng dữ liệu lớn:

Hai chữ V khác đã xuất hiện trong vài năm qua: giá trị và tính xác thực. Dữ liệu có giá trị nội tại. Nhưng nó không có ích lợi gì cho đến khi giá trị đó được phát hiện. Điều quan trọng không kém: Dữ liệu của bạn trung thực đến mức nào — và bạn có thể dựa vào nó ở mức độ nào? Ngày nay, dữ liệu lớn đã trở thành vốn. Hãy nghĩ về một số công ty công nghệ lớn nhất thế giới. Một phần lớn giá trị mà họ cung cấp đến từ dữ liệu của họ.

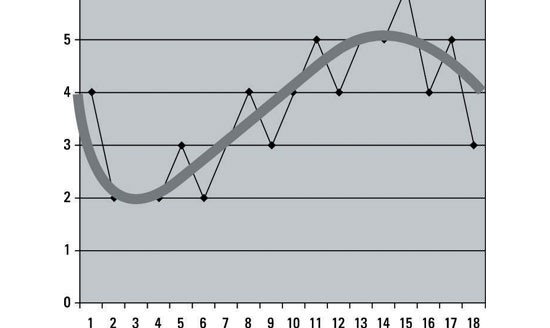

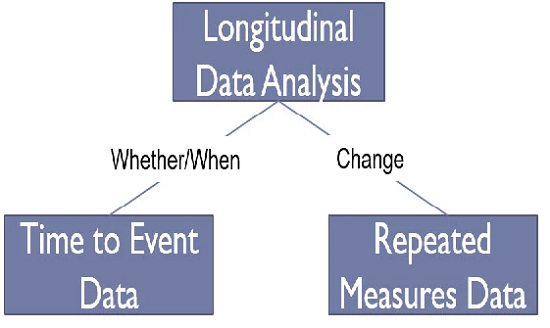

Dữ liệu này được họ liên tục phân tích để tạo ra hiệu quả hơn và phát triển các sản phẩm mới. Những đột phá công nghệ gần đây đã làm giảm chi phí lưu trữ và tính toán dữ liệu theo cấp số nhân, khiến việc lưu trữ nhiều dữ liệu trở nên dễ dàng và ít tốn kém hơn bao giờ hết. Với khối lượng dữ liệu lớn ngày càng tăng, giá thành rẻ hơn và dễ tiếp cận hơn, bạn có thể đưa ra các quyết định kinh doanh chính xác và chính xác hơn. Tìm kiếm giá trị trong dữ liệu lớn không chỉ là phân tích nó (đó là một lợi ích hoàn toàn khác). Đó là toàn bộ quá trình khám phá yêu cầu các nhà phân tích sâu sắc, người dùng doanh nghiệp và giám đốc điều hành, những người đặt câu hỏi phù hợp, nhận ra các mẫu, đưa ra các giả định sáng suốt và dự đoán hành vi.

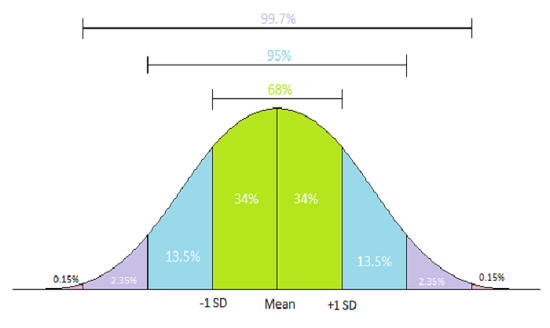

Các nhà phân tích dữ liệu xem xét mối quan hệ giữa các loại dữ liệu khác nhau, chẳng hạn như dữ liệu nhân khẩu học và lịch sử mua hàng, để xác định liệu có tồn tại mối tương quan hay không. Các đánh giá như vậy có thể được thực hiện trong nhà hoặc bên ngoài bởi bên thứ ba tập trung vào việc xử lý dữ liệu lớn thành các định dạng dễ tiêu hóa.

Các doanh nghiệp thường sử dụng việc đánh giá dữ liệu lớn của các chuyên gia như vậy để biến nó thành thông tin có thể hành động. Nhiều công ty, chẳng hạn như Alphabet và Meta (trước đây là Facebook), sử dụng dữ liệu lớn để tạo doanh thu quảng cáo bằng cách đặt quảng cáo được nhắm mục tiêu đến người dùng trên phương tiện truyền thông xã hội và những người đang lướt web. Gần như mọi bộ phận trong công ty đều có thể sử dụng những phát hiện từ phân tích dữ liệu, từ nguồn nhân lực và công nghệ cho đến tiếp thị và bán hàng. Mục tiêu của dữ liệu lớn là tăng tốc độ đưa sản phẩm ra thị trường, giảm thời gian và nguồn lực cần thiết để đạt được sự chấp nhận của thị trường, đối tượng mục tiêu và đảm bảo khách hàng vẫn hài lòng.

3. Ưu điểm và nhược điểm của Dữ liệu lớn:

Sự gia tăng số lượng dữ liệu có sẵn mang lại cả cơ hội và vấn đề. Nói chung, có nhiều dữ liệu hơn về khách hàng (và khách hàng tiềm năng) sẽ cho phép các công ty điều chỉnh sản phẩm và nỗ lực tiếp thị tốt hơn để tạo ra mức độ hài lòng cao nhất và lặp lại hoạt động kinh doanh. Các công ty thu thập một lượng lớn dữ liệu được tạo cơ hội để thực hiện các phân tích sâu hơn và phong phú hơn vì lợi ích của tất cả các bên liên quan.

Với số lượng dữ liệu cá nhân có sẵn về các cá nhân ngày nay, điều quan trọng là các công ty phải thực hiện các bước để bảo vệ dữ liệu này; một chủ đề đã trở thành một cuộc tranh luận sôi nổi trong thế giới trực tuyến ngày nay, đặc biệt là với nhiều vụ vi phạm dữ liệu mà các công ty đã trải qua trong vài năm qua.Mặc dù phân tích tốt hơn là một điều tích cực, nhưng dữ liệu lớn cũng có thể tạo ra quá tải và nhiễu, làm giảm tính hữu ích của nó. Các công ty phải xử lý khối lượng dữ liệu lớn hơn và xác định dữ liệu nào đại diện cho tín hiệu so với nhiễu.

Quyết định điều gì làm cho dữ liệu có liên quan trở thành một yếu tố quan trọng. Hơn nữa, bản chất và định dạng của dữ liệu có thể yêu cầu xử lý đặc biệt trước khi nó được xử lý. Dữ liệu có cấu trúc, bao gồm các giá trị số, có thể được lưu trữ và sắp xếp dễ dàng. Dữ liệu phi cấu trúc, chẳng hạn như email, video và tài liệu văn bản, có thể yêu cầu áp dụng các kỹ thuật phức tạp hơn trước khi nó trở nên hữu ích.